Sull'affidabilità dei modelli climatici computerizzati

Nicola SCAFETTA

Università degli Studi di Napoli Federico II – Dipartimento di Scienze della Terra, dell’Ambiente e delle Georisorce – Complesso Universitario di Monte S. Angelo via Cinthia, 21 – 80126 Napoli, Italia

Autore: nicola.scafetta@unina.it

Copyright © 2020: Tutti i diritti riservati all’Autore.

15 Marzo 2020

Questo articolo è un aggiornamento, basato su una traduzione dell’articolo:

Scafetta, N., 2019. On the reliability of computer climate models. Italian Journal of Engineering Geology and Environment, IJEGE 2019, 49-70. Sito dell’articolo

Sommario

Dal 1850 il clima della Terra si è riscaldato di circa 0.9°C, e di circa 0.5°C dal 1950. Questo fenomeno è noto come il “Riscaldamento Globale” oppure “Global Warming”. Simultaneamente, la concentrazione atmosferica di alcuni gas serra, principalmente dell’anidride carbonica (CO2), è aumentata soprattutto a causa della combustione dei combustibili fossili quali il carbone, il metano e i derivati del petrolio. Ci

si chiede, quindi, quanto l’uomo abbia contribuito a questo cambiamento climatico, e cosa potrebbe succedere in un futuro prossimo. Affrontare questo argomento è fondamentale perché le previsioni climatiche determinano importanti politiche economiche.

Se i prossimi cambiamenti climatici fossero significativi e dannosi, sarebbe necessario mitigarli sin d’ora riducendo le emissioni di gas serra: cosa che, però, comporterebbe gravi oneri economici perché significherebbe rinunciare subito ai benefici dei combustibili fossili. Se, al contrario, nei prossimi decenni i cambiamenti climatici sono moderati, sarà sufficiente adattarsi ad essi applicando misure economicamente affordabili.

Usando le interpretazioni climatiche prodotte da alcuni modelli climatici dinamici computerizzati, come i Global Climate Models (GCM), l’Intergovernmental Panel on Climate Change (IPCC) delle Nazioni Unite è arrivato alla conclusione che i forzanti antropici siano stati gli unici responsabili (cioè al 100%) del riscaldamento osservato dal periodo pre-industriale (1850-1900) ad oggi. L’argomento proposto è che i forzanti naturali (variazioni nell’irragiamento solare e le eruzioni vulcaniche) da soli non sarebbero stati in grado di produrre nessun riscaldamento dal periodo pre-industriale, e neppure dagli anni 1950 a oggi. Se le emissioni di CO2 non saranno drasticamente e immediatamente ridotte, questi stessi modelli prevedono un riscaldamento climatico di oltre 1.5°C dal 2030 e di 4-5°C, entro il 2100, rispetto al periodo 1850-1900.

Quindi, l’IPCC propone urgenti e massicce misure di mitigazione perché questi stessi modelli prevedono che un ulteriore aumento di CO2 indurrà cambiamenti climatici troppo pericolosi per l’ambiente e le società umane.

L’argomento fondamentale è determinare se questi modelli sono affidabili. Per farlo occorre dimostrare che essi sono in grado di ricostruire correttamente i climi del passato. Tuttavia, in questo lavoro mostrerò che questi modelli non riescono a ricostruire adeguatamente la variabilità naturale del clima durante gli ultimi 10000 anni – noti come il periodo dell’Olocene – e questo avviene su tutte le scale temporali. In modo particolare questi modelli non ricostruiscono:

- il lungo periodo caldo noto come l’Holocene Climatic Optimum (9000-6000 anni fa) con il successivo raffreddamento osservato da 5000 anni fa ad oggi;

- le grandi oscillazioni millenarie dell’Olocene le cui fasi calde comprendono, ad esempio, il Periodo Caldo Medievale e, mille anni prima, il Periodo Caldo Romano intervallati da periodi freddi come i Secoli Bui e la Piccola Era Glaciale;

- diverse oscillazioni climatiche più brevi con periodi di circa 9.1, 10.4, 20, e 60 anni; la tendenza del riscaldamento globale dal 2000 ad oggi, che i GCM sovrastimano per almeno un fattore 2.

Le implicazioni fisiche di questi risultati sono due:

- la sensibilità climatica all’equilibrio (ECS) dei GCM al forzante radiativo (misurato come un raddoppio di CO2 atmosferico) è sovrastimata in media almeno per un fattore 2 (numerosi studi recenti suggeriscono la ECS realistica sia tra 1°C e 2°C);

- esistono forzanti climatici solari e astronomici che sono ancora incerti o sconosciuti e che, quindi, mancano nei GCM, e che probabilmente modulano direttamente il sistema nuvoloso e/o le oscillazioni oceaniche che sono i principali meccanismi che inducono i cambiamenti climatici.

Quindi, le evidenze empiriche suggeriscono che gli attuali GCM sovrastimano notevolmente il contributo antropico mentre sottostimano quello naturale. L’unica conclusione è che questi modelli non sono sufficientemente sviluppati per interpretare e prevedere i cambiamenti climatici con una soddisfacente affidabilità scientifica.

L’alternativa è usare modelli climatici semi-empirici presenti nella letteratura scientifica ma ignorati dall’IPCC. Questi non hanno la pretesa, in realtà del tutto velleitaria, di ricostruire tutti gli aspetti climatici come i GCM, ma possono essere più affidabili per compiti specifici. I modelli empirici cercano di modellare direttamente la dinamica climatica partendo dalle informazioni contenute nei dati stessi e tipicamente prevedono che la variabilità solare possa avere contribuito almeno il 50% del riscaldamento globale osservato dal 1850-1900 ad oggi. I dati climatici mostrano anche una variabilità naturale costituita da diverse oscillazioni (con periodi di circa 9.1, 10.4, 20, 60, 115, 1000 anni, ed altri) che sono coerenti con note oscillazioni solari, lunari e astronomiche. I modelli empirici che utilizzano queste oscillazioni insieme ad un contributo antropico e vulcanico (uguale però alla metà di quello prodotto dai GCM) riproducono ottimamente la variazione climatica osservata sin dal 1850 ad oggi.

Inoltre, essi predicono un riscaldamento piuttosto moderato da 2000 al 2040 e un riscaldamento di circa 2°C dal 2000 al 2100, utilizzando gli stessi scenari di emissione antropici utilizzati per le simulazioni climatiche del XXI secolo prodotte dai GCM.

Quindi, i risultati empirici suggeriscono che le politiche di adattamento, che sono molto più affordabili di quelle di mitigazione, saranno più che sufficienti per affrontare i cambiamenti climatici che potrebbero verificarsi nei prossimi decenni.

Parole chiave: cambiamento climatico, riscaldamento globale, modelli di circolazione generale, interazioni solare-climatico, test di validazione.

INTRODUZIONE

Fin dal periodo preindustriale (1850-1900), la superficiale globale della Terra si è riscaldata di circa 0,9 °C e dagli anni ’50 di circa 0,5° C (Figura 1, curva nera). Questo riscaldamento è avvenuto durante un significativo aumento della concentrazione atmosferica di alcuni gas a effetto serra (GHG), in particolare dell’anidrite carbonica (CO2) principalmente emessa con la combustione di combustibili fossili.

Secondo l’interpretazione dei modelli climatici computerizzati – ad es. i Coupled Model Intercomparison Project Phase 3 e 5 Global Climate Models (CMIP3 e CMIP5 GCM) – adottati dal Gruppo Intergovernativo sui Cambiamenti Climatici delle Nazioni Unite (IPCC, 2013) (Intergovernmental Panel on Climate Change) le emissioni antropiche dovrebbero essere considerate responsabili di quasi la totalità (100%) del riscaldamento osservato sin dal periodo preindustriale, cioè sin dal 1850-1900. Infatti, nell’ultimo rapporto dell’IPCC (2018) si afferma chiaramente: “Si stima che le attività umane abbiano causato un riscaldamento globale di circa 1,0°C rispetto ai livelli preindustriali, con un

intervallo probabile tra 0,8 e 1,2 °C”, mentre la “la temperatura superficiale media globale (GMST) osservata nel decennio 2006–2015 è stata di 0,87 °C (probabile tra 0,75 °C e 0,99 °C) più alta rispetto alla media nel periodo 1850–1900”. Pertanto, l’IPCC ritiene che le emissioni antropiche abbiano causato essenzialmente il 100% del riscaldamento globale osservato dal 1850-1900 fino ai nostri giorni.

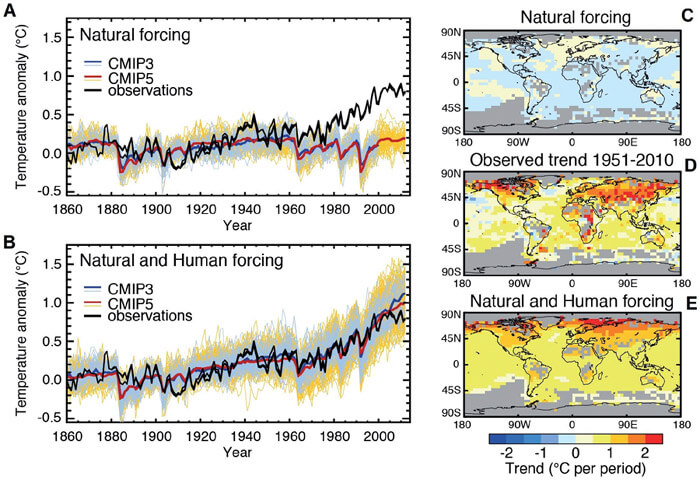

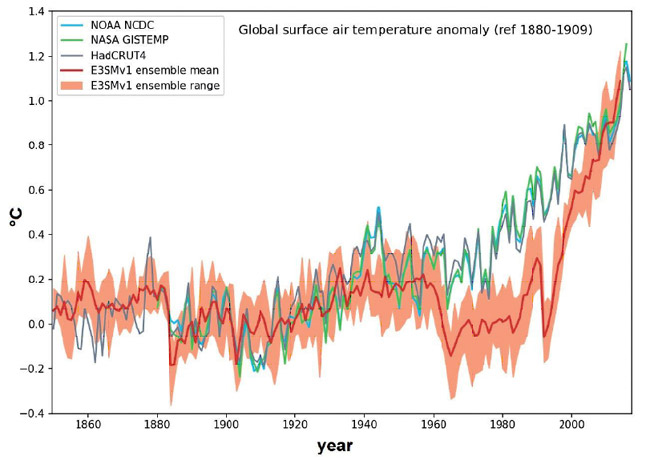

Questo risultato deriva da simulazioni climatiche al computer come quelle mostrate nella Figura 1 che mostra alcuni risultati di esperimenti climatici “virtuali”, cioè al computer, eseguiti in due diverse situazioni fisiche. Nel primo caso, vengono utilizzati solo quelli che sono ritenuti essere i forzanti climatici naturali. Questi sono il risultato dei forzanti radiativi dedotti dalla variazione dell’irragiamento solare e dall’eruzione dei vulcani. Questi primi risultati sono riportati nella Figura 1A e mostrano che, secondo questi modelli, i forzanti naturali da soli non avrebbero potuto produrre alcun riscaldamento dal 1870 al 2010. Infatti, i valori medi delle simulazioni al computer (curve rosse e blu) mostrano quasi lo stesso livello di anomalia termica (che nella figura è data dal valore 0,2 °C) nei periodi 1860-1880, 1940-1960 e 2000-2015. Pertanto, questo esperimento informatico implica che i forzanti naturali da soli non avrebbero potuto causare alcun riscaldamento negli ultimi 150 anni. Al contrario, la Figura 1B mostra che quando si usano tutti i forzanti climatici noti, cioè quando si considerano insieme quelli

naturali e quelli antropici, gli stessi modelli appaiono riprodurre approssimativamente il riscaldamento di 0,9 °C osservato dal 1860. Questi risultati vengono interpretati come se solo il forzante antropico potesse spiegare il riscaldamento osservato e questo è anche il motivo per cui il riscaldamento globale osservato sin dal 1850-1900 è stato classificato come “antropico” (IPCC, 2013).

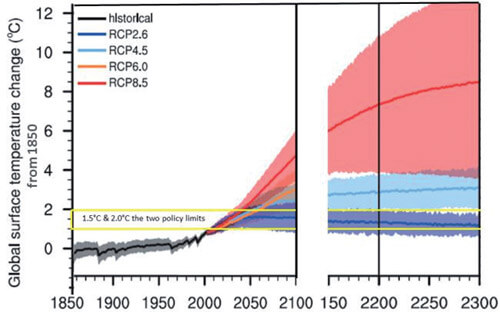

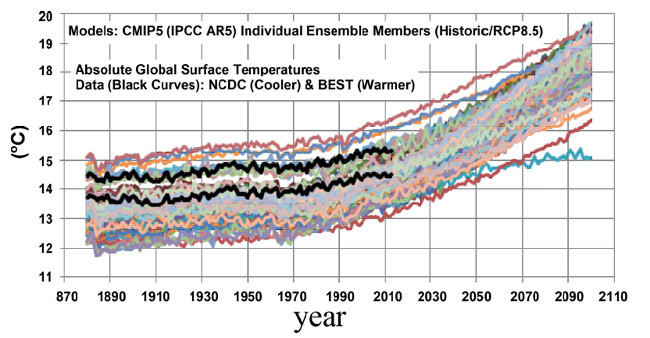

Gli stessi modelli climatici computerizzati vengono poi utilizzati per ottenere proiezioni climatiche globali per il XXI secolo (Figura 2). Queste simulazioni previsionali si basano su alcune ipotesi riguardanti possibili emissioni future di gas-serra chiamate Representative Concentration Pathways (RCP).

Esistono quattro diversi scenari: RCP 2.6 ipotizza che le emissioni annuali globali di gas serra raggiungano il picco tra il 2010-2020 e calino successivamente; possiamo già ritenere questo scenario non realistico. RCP 4.5 assume un picco di emissione intorno al 2040 seguito da un calo. In RCP 6.0, le emissioni raggiungono il picco intorno al 2080 e, quindi, diminuiscono. In RCP 8.5, le emissioni continuano ad aumentare durante tutto il XXI secolo.

Figura 1 - Confronto tra l’osservazione della variazione globale della temperatura superficiale (nero) e delle simulazioni del modello computerizzato CMIP3 e CMIP5 utilizzando il solo impatto (forzatura) naturale e l’impatto (forzatura) sia naturale sia umano. Fonte IPCC (2013), FAQ 10.1. Secondo questi modelli, il solo impatto naturale non avrebbe indotto alcun riscaldamento dal 1870 al 2010. Il riscaldamento osservato è, quindi, ritenuto antropico al 100%.

La Figura 2 mostra che se le emissioni di CO2 non sono sostanzialmente mitigate, ad es. se si segue lo scenario 8.5 RCP, secondo i suddetti modelli climatici la temperatura superficiale globale potrebbe aumentare fino a circa 4-5 °C al di sopra del periodo preindustriale 1860-1900, e continuerà a crescere nei secoli successivi (IPCC, 2013, 2018).

Sulla base di queste simulazioni l’IPCC (2018) conclude che il riscaldamento globale della superficie terrestre raggiungerà i 1,5 °C al di sopra del periodo preindustriale intorno al 2030, cosa che potrebbe potenzialmente mettere in difficoltà molte società umane a causa dell’impossibilità di adattarsi ad imminenti e rapidi cambiamenti climatici che potrebbero indurre un pericoloso innalzamento del livello del mare ed un aumento di eventi meteorologici estremi, minacciando anche diversi ecosistemi naturali ed altro.

Figura 2 - Proiezione del riscaldamento globale della temperatura superficiale delle simulazioni dei modelli computerizzati CMIP5 utilizzando diversi ipotesi di emissioni (RCP) per il 21° secolo. Fonte IPCC [1].

Pertanto, le proiezioni di questi modelli climatici sono utilizzate per giustificare costose politiche di mitigazione finalizzate a ridurre significativamente l’emissione di gas serra antropici al fine di mantenere il riscaldamento globale della superficie al di sotto di 1,5 / 2,0 °C rispetto al periodo preindustriale il più a lungo possibile.

Nel suo insieme, questa interpretazione del sistema climatico e dei suoi cambiamenti è nota come la teoria antropica del riscaldamento globale (AGWT) ed è stata ampiamente sostenuta dall’IPCC almeno dal 2001.

Tuttavia, tutti i modelli fisici, inclusi ovviamente i CMIP5 GCM, devono essere convalidati per essere considerati una rappresentazione valida di un sistema naturale qual è il clima del pianeta Terra. Pertanto, è necessario richiedere che anche i modelli utilizzati per interpretare i cambiamenti climatici siano supportati da solide evidenze sperimentali.

Nell’eventualità che tale convalida fallisca, le proiezioni previsionali dell’IPCC per il XXI secolo non sarebbero affatto affidabili. Pertanto, è fondamentale affrontare questo problema anche perché vi è un numero crescente di lavori che mostrano che i modelli CMIP3 e CMIP5 non ricostruiscono correttamente la variabilità naturale del clima e che questo avvenga su tutte le scale temporali da quella annuale a quella multi-millenaria.

Moltissime evidenze suggeriscono che questi modelli sovrastimino significativamente gli effetti climatici delle emissioni antropiche mentre delle interpretazioni alternative sono state sviluppate: vedi ad esempio Idso et al. (2013; 2016).

Infatti, occorre puntualizzare che i risultati mostrati in Figura 1 non dimostrano affatto che il riscaldamento osservato dal periodo 1850-1900 è stato dovuto alle emissioni umane. Infatti, la Figura 1 non mostra un “fatto” ma propone una “ipotesi” essendo tale risultato solo la previsione di modelli climatici computerizzati, non di risultati sperimentali. La vera “ipotesi” che questi modelli propongono è che la variabilità naturale da sola non sarebbe stata capace di indurre nessun riscaldamento globale sin dal periodo preindustriale (Figura 1A). Tuttavia, in scienza uno dovrebbe dimostrare un tale risultato

con un vero esperimento naturale, che però manca. Infatti, una Terra gemella senza esseri umani non è disponibile per un confronto e una verifica sperimentale diretta dei risultati mostrati nella figura. Tecnicamente, si dovrebbe dimostrare che su un altro pianeta del tutto simile al nostro ma senza l’uomo, la temperatura non sarebbe aumentata dal 1850-1900. In mancanza di tale verifica diretta, l’unico modo per convalidare un modello climatico è verificare se esso è capace di ricostruire correttamente i cambiamenti climatici del passato e questo dovrebbe essere fatto su tutte le scale temporali rilevanti per capire i cambiamenti climatici dell’ultimo secolo: cioè dalla scala decennale a quella millenaria.

Al contrario, l’errore che comunemente si fa è di assumere che i modelli climatici siano già convalidati per il fatto stesso di esistere, ma non è così che la scienza funziona.

E’ interessante considerare che un recente sondaggio tra oltre 4000 membri dell’American Meteorological Society (Maibach et al., 2016) ha rivelato che il 96% degli intervistati riconosce che si sta verificando un cambiamento climatico. Infatti, tutti sono d’accordo che il clima cambia e sta cambiando e che quindi l’accusa che i sostenitori del AGWT spesso muovono contro i loro critici di “negare” il cambiamento climatico non ha senso. Il vero problema è capire quanto di questo cambiamento è naturale e quanto è da ascrivere all’uomo. Il fatto interessante di questo sondaggio è che poi pone quesiti molto più specifici. Ad esempio, per quanto riguarda le cause fisiche del cambiamento climatico in atto, lo stesso sondaggio conclude che solo il 29% degli intervistati è d’accordo con l’affermazione secondo cui l’80-100% del riscaldamento globale della superficie osservato dal 1960 è stato indotto dall’attività umana. Tuttavia, un altro 38% afferma che gli esseri

umani sono stati responsabili del 60-80% del riscaldamento osservato, mentre un altro 26% afferma che i fattori climatici naturali hanno contribuito dal 40% al 100%. Il 6% non ha saputo rispondere e solo l’1% ritiene che non si sia verificato alcun cambiamento climatico. Quindi, solo una minoranza, probabilmente molto meno di un terzo dei meteorologi statunitensi concorda con l’affermazione dell’IPCC secondo cui la totalità (100%) del riscaldamento osservato dal 1850-1900 o dal 1960 è stato antropico.

Pertanto, non è affatto vero che esiste un consenso quasi totale, si dice il 97%, sulla principale tesi dell’IPCC.

In questa breve rassegna critica riassumerò brevemente alcuni dei motivi principali per cui l’AGWT dovrebbe essere messa in discussione. Cercherò di spiegare perché così tante persone con una certa conoscenza ed esperienza su questo argomento sono scettiche sull’AGWT prodotto dai modelli climatici. Inoltre illustrerò un’interpretazione alternativa dei cambiamenti climatici basata su modelli semi-empirici, discussi nella letteratura scientifica, ma ignorati dall’IPCC. Questa interpretazione alternativa dei cambiamenti climatici si basa sull’evidenza che il clima della Terra è determinato da specifiche oscillazioni naturali su più scale temporali che implicano una riduzione degli effetti antropici e vulcanici. I risultati concordano meglio con i dati storici e, quindi, le previsioni climatiche per il prossimo futuro ottenute con questi modelli semiempirici sono ragionevolmente più affidabili su scala globale di quelle dei modelli GCM adottati dall’IPCC: vedi ad esempio Scafetta (2013a; 2013b).

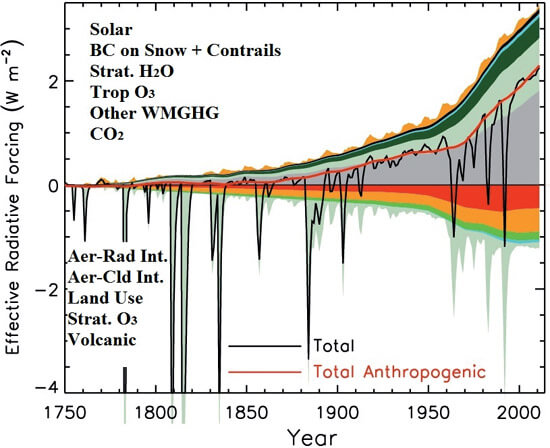

Figura 3- Dall'alto verso il basso: elenco delle funzioni di forzatura radiativa utilizzate nei modelli numerici usati nell’interpretare il clima della Terra (IPCC, 2013).

L'INCERTEZZA NELL’EQUILIBRIO DELLA SENSIBILITÀ DEL CLIMA AL FORZANTE RADIATIVO

La modellazione GCM del clima si basa su una complessa serie di equazioni differenziali accoppiate che descrivono le circolazioni dell’atmosfera e dell’oceano di vari fenomeni climatici e su una serie di funzioni di forzature radiative esterne che influenzano il sistema come quelle illustrate nella Figura 3. Se le funzioni di forzatura fossero costanti, il sistema climatico al massimo fluttuerebbe attorno a un valore medio come un correlato rumore rosso. Pertanto, l’evoluzione temporale delle funzioni di forzatura è necessaria per indurre un cambiamento climatico in un periodo sufficientemente lungo. Determinare le funzioni di forzatura corrette del sistema è uno dei principali problemi scientifici perché non è possibile a priori sapere se tutte le funzioni di forzatura sono già note.

Ad esempio, i forzanti illustrati nella Figura 3 suggeriscono che la variazione dell’irraggiamento solare (la curva gialla ondeggiante in cima) è stata quasi trascurabile relativa agli altri contributi, sin dal 1750. Tuttavia, qui ci sono due principali questioni aperte che non andrebbero ignorate:

- la variabilità secolare della luminosità solare è ancora oggetto di dibattiti perché alcuni studi scientifici mostrano una sua variabilità secolare molto piccola, persino solo 0,6 W/m2 dal 1700 ad oggi (Wang et al., 2005), mentre altri studi suggeriscono una variabilità secolare molto ampia fino a dieci volte tanto, cioè 0,6 W/m2 durante lo stesso periodo (Ergonova et al., 2018);

- ci sono anche diverse indicazioni che il sole induce cambiamenti climatici per mezzo di un forzante

corpuscolare associato alla modulazione del flusso di raggi cosmici indotta dal suo campo magnetico. I raggi cosmici ed altri corpuscoli cosmici ed interplanetari che raggiungono la Terra potrebbero modulare direttamente la copertura nuvolosa e quindi l’albedo terrestre inducendo notevoli cambiamenti climatici (Kirkby, 2007; Svensmark et al., 2017).

Forzanti corpuscolari legati all’attività solare, di natura astronomica e persino le forzanti mareali che tutti conoscono mancano completamente nei modelli GCM. I forzanti climatici tipici utilizzati nei modelli climatici CMIP5 sono mostrati in Figura 3 e sono quelli dedotti dai cambiamenti delle concentrazioni di GHG atmosferici come il CO2, CH4, ecc., dalla variazione di concentrazione di aerosol atmosferico dovuta sia alle eruzioni vulcaniche che a varie attività antropiche, dal cambiamento di uso del suolo, e dall’evoluzione della radiazione solare totale. I modelli normalmente usano la ricostruzione della luminosità solare proposta da Wang et al. (2005) che minimizza nei GCM l’effetto solare sul clima. La figura, quindi, riassume i forzanti adottati nei modelli per il periodo storico dal 1750 al 2005.

Un’ulteriore affermazione implicita avanzata dall’IPCC è che, ad eccezione dei forzanti dovuti alla variazione della luminosità solare e alle eruzioni vulcaniche, tutte le altre forzanti climatiche hanno solo un’origine antropica sin dal 1750. Questa affermazione, tuttavia, è sicuramente errata perché anche i cambiamenti climatici naturali possono indurre cambiamenti nell’atmosfera di gas serra, alterare i suoli, ecc. Ad esempio, il rilascio o l’assorbimento di CO2 da parte dell’oceano dipende dalla sua temperatura

superficiale. Va anche specificato che il vapore acqueo (H2O) è il più importante dei gas serra del pianeta ma non è incluso tra i forzanti dei modelli climatici perché è un “feedback” del sistema la cui evoluzione, come quella delle nuvole, è, in principio, calcolata direttamente dalle equazioni fisiche implementate nei modelli. Questo approccio, tuttavia, non sarebbe affatto esaustivo se, ad esempio, mancassero all’appello alcuni forzanti come quelli corpuscolari di origine astronomica discussi sopra.

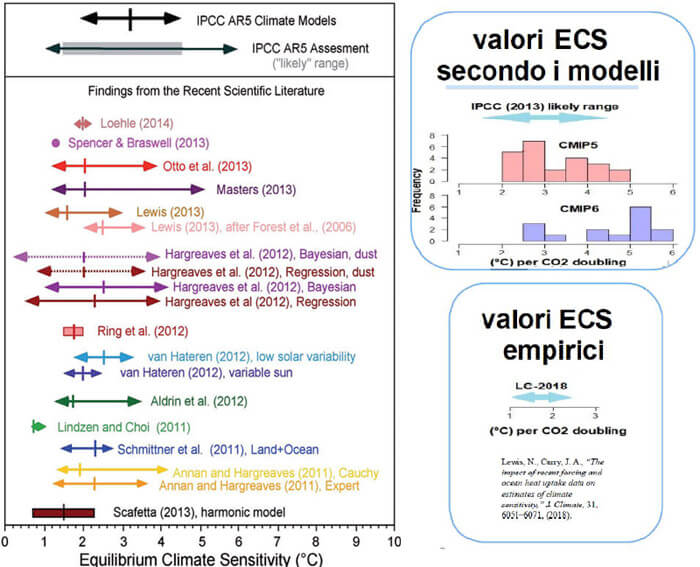

Ora, il punto fondamentale da comprendere è che il parametro climatico più importante è la “sensibilità climatica all’equilibrio” (ECS) al forzante radiativo. Essa indica il riscaldamento climatico globale della superficie del pianeta che sarebbe indotto da un raddoppio della quantità di CO2 atmosferico (che corrisponderebbe ad un aumento di forzante radiativo di circa 3.7 W/m2) una volta raggiunto l’equilibrio termico. In assenza di amplificazioni climatiche, questo aumento radiativo indurrebbe un riscaldamento di circa 1 °C secondo la legge di Stefan-Boltzmann e il risultato può essere considerato realistico. Tuttavia, il problema è stimare i vari feedback climatici – cioè la riposta del sistema nuvoloso, dell’oceano, della vegetazione e dei ghiacciai – il che è ancora estremamente incerto. Quindi, i modelli CMIP3 e CMIP5 e molti numerosi studi empirici danno stime piuttosto ballerine dell’ECS. Essi nel complesso stimano che se la concentrazione atmosferica di CO2 raddoppiasse, ad esempio, se si passasse dal livello preindustriale di 280 ppm a 560 ppm – ora siamo a circa 415 ppm – il sistema climatico potrebbe riscaldarsi tra 1 e 6 °C (Lewis, 2013; Knutt i et al., 2017). La Figura 4 confronta

una serie di queste stime.

Il primo problema che risalta subito all’occhio è l’eccessiva incertezza del valore dell’ECS: secondo le conoscenze attuali lo stesso forzante radiativo potrebbe causare un riscaldamento che va da un minimo di circa 1° ad un valore sei volte maggiore, circa 6 °C. Come detto, questa incertezza è dovuta principalmente alla scarsa capacità dei modelli di riprodurre i vari feedback climatici, inclusa la modellazione del vapore acqueo e del sistema nuvoloso.

Figura 4- Confronto tra le stime della sensibilità climatica al forzante radiativo indotto da un raddoppio della concentrazione atmosferica di CO2 (cfr. IPCC, 2013; Scafetta, 2013; Lewis, 2013). Nota la grande incertezza e la discrepanza osservata tra i valori ottenuti con i modelli GCM e quelli dedotti empiricamente dai dati.

Tuttavia, c’è un aspetto importante che andrebbe sottolineato: numerosi studi recenti mostrano che l’ECS dedotto dai modelli è molto probabilmente sopravvalutato e che una stima realistica dell’ECS è tra 0,75 e 2,25 °C con una media di 1,5 °C: vedi, ad esempio, Scafetta (2013a), Gervais (2016) e Lewis & Curry (2015; 2018).

Questo valore è almeno la metà dell’ECS medio dedotto dei modelli CMIP3 e CMIP5, che è di circa 3 °C. Infatti, anche Knutti et al. (2017), che hanno esaminato in dettaglio la letteratura su questo argomento, hanno riconosciuto che: “… evidenze dalla modellistica climatica favoriscono i valori di ECS della parte superiore dell’intervallo probabile, mentre molti studi recenti basati sul riscaldamento registrato strumentalmente – e alcuni dal paleoclima – favoriscono i valori della parte inferiore dell’intervallo”. Pertanto, una vistosa discrepanza tra i dati climatici e le previsioni teoriche dei modelli sta diventando sempre più evidente. I nuovi modelli, i CMIP6, addirittura predicono valori dell’ECS

ancora più alti del CMIP5 e CMIP3 aumentando così la discrepanza con le evidenze empiriche.

Questo risultato indica che la reale sensibilità climatica al forzante radiativo – come determinato ora da diversi autori – potrebbe essere circa la metà, o anche un terzo o meno (ad esempio: Lindzen & Choi, 2011; Bates, 2016) rispetto a quanto calcolato e implementato dai GCM utilizzati dall’IPCC su cui si basano le simulazioni climatiche mostrate nella Figura 1 e le previsioni allarmiste mostrate in Figura 2. Quindi, se il valore dell’ECS è basso, come tanti studi moderni suggerirebbero, questo metterebbe in dubbio le conclusioni scientifiche dell’IPCC (2001; 2007; 2013, 2018) Cioè, metterebbe in discussione l’interpretazione dell’IPCC sia riguardo il riscaldamento osservato durante il 20° secolo che le loro proiezioni climatiche catastrofiche del 21° secolo. Se il valore vero dell’ECS è circa la metà o meno di quello che implementano i GCM, allora anche il riscaldamento antropico sarebbe almeno la metà, o meno, di ciò che questi modelli predicono.

Alcuni potrebbero obbiettare che se il valore dell’ECS è basso, allora i forzanti radiativi noti mostrati in Figura 3 ed implementati nei GCM non sarebbero più capaci di ricostruire il riscaldamento di circa 0.9 °C osservato dal periodo 1850-1900. Questo significa semplicemente che si dovrebbero considerare forzanti climatici diversi oppure alternativi. Ad esempio, potrebbe esserci la necessità di utilizzare funzioni della variazione della luminosità solare con una maggiore variabilità secolare, oppure si dovrebbero cercare ulteriori forzanti climatici che al momento sono sconosciuti, ecc.

Quest’ultima eventualità renderebbe impossibile studiare i cambiamenti climatici con modelli dinamici come i GCM che, essendo basati su un principio riduzionista, richiedono a priori la conoscenza di tutti i meccanismi climatici e dei loro forzanti. Questo lascerebbe spazio solo ai modelli empirici.

EVIDENZE DI UNA GRANDE VARIABILITÀ CLIMATICA NATURALE NON RIPRODOTTA DAI MODELLI CLIMATICI

Esistono diverse evidenze empiriche che i modelli climatici usati per sostenere l’AGWT falliscono macroscopicamente nel riprodurre le variazioni climatiche osservate durante l’intero periodo dell’Olocene, cioè durante il periodo interglaciale recente durante il quale le società umane si sono sviluppate da circa 10000 anni fa ai giorni nostri. Per quanto riguarda il periodo precedente, su una scala temperale di diverse centinaia di migliaia di anni, Shakun et al. (2012) hanno mostrato che il riscaldamento globale ha preceduto i cambiamenti nelle concentrazioni di anidride carbonica e, quindi, la concentrazione atmosferica di CO2 si è comportata come un feedback variando come risposta alla variazione climatica della Terra indotta da variazioni orbitali del nostro pianeta note come i cicli di Milankovich. A tale riguardo, si può anche ricordare che i periodi interglaciali che hanno preceduto il nostro sono stati più caldi dell’Olocene. Ad esempio, durante l’Eemiano occorso circa 120 mila anni fa, i livelli del mare erano almeno 6-7 metri più alti del periodo contemporaneo e a latitudini nordiche come ad esempio a Londra sono stati trovati fossili di animali tropicali come ippopotami. Per i nostri fini, tuttavia, è importante comprendere la dinamica dei cambiamenti climatici dell’ultimo interglaciale e, quindi, cerchiamo ora di chiarificare quello che è successo durante l’Olocene.

Il clima dell’Olocene vs. le previsioni dei modelli

Le ricostruzioni della temperatura dell’Olocene (Alley, 2004; Shakun et al., 2012; Marcott et al., 2013) suggeriscono che il periodo tra circa 9500 e 5500 anni fa è stato piuttosto caldo. Quest’epoca è nota come l’Ottimo dell’Olocene. Dopo di essa la temperatura è andata raffreddandosi fino ai giorni nostri di almeno 1,0 °C su una scala millenaria perché la Terra sta lentamente scivolando nella prossima fase glaciale determinata dai cicli orbitali di Milankovich.

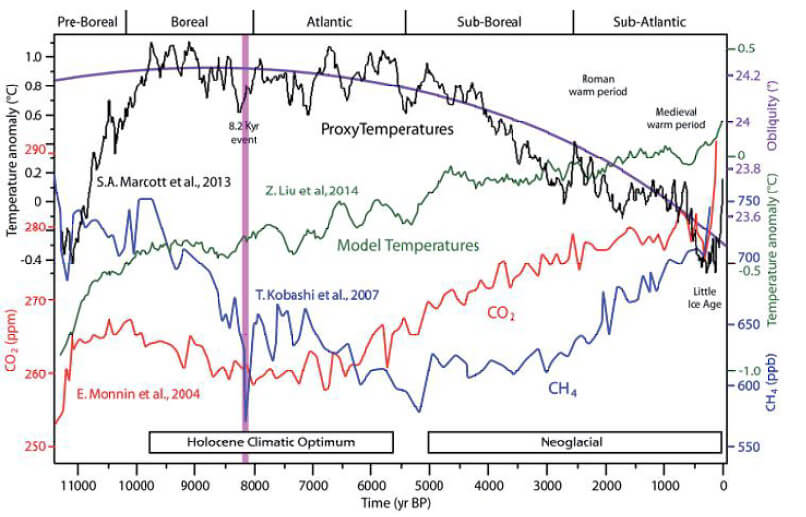

Figura 5- Temperatura da proxy (nero), ricostruzione della temperatura del modello climatico (verde), concentrazioni atmosferiche di CO2 e CH4 valutate (curve rosse e blu) e forzatura dell'obliquità dell'insolazione (viola). Fonte Javier (2017) basato su Liu et al. (2014). Si noti che la temperatura diminuisce mentre i modelli computerizzati mostrano un aumento della temperatura durante l'Olocene.

Una prima domanda da porsi è se i modelli climatici sono stati in grado di riprodurre questa dinamica. La Figura 5 mostra la registrazione di temperatura dell’Olocene di Marcott et al. (2013) in nero contro una tipica simulazione dei modelli climatici (vedi Liu et al., 2014), e contro delle stime della concentrazione atmosferica di due gas serra usati come forzanti nei modelli climatici: il CO2 (Monn in et al., 2004) e il CH4 (Kobashi et al., 2007). Il grafico mostra che la concentrazione di CO2 atmosferico è aumentata monotonicamente durante tutto l’Olocene e che i modelli (curva verde) hanno predetto un riscaldamento monotonico di circa 1 °C che si correla perfettamente all’andamento mostrato dai gas serra. Tuttavia, il problema è che la predizione del modello non si correla affatto con l’andamento della temperatura per millenni perché essa sale, raggiunge il massimo durante l’Ottimo e poi ridiscende fino ai giorni nostri.

Questa osservazione da sola suggerisce che i modelli sono troppo sensibili alla variazione di CO2 e di CH4 mentre non simulano correttamente l’effetto della variazione della luminosità solare. Infatti, su queste scale temporali il raffreddamento climatico osservato dall’Ottimo dell’Olocene ai tempi attuali è stato per lo più indotto dalla variazione dell’insolazione dovuta all’oscillazione dell’obliquità dell’asse terrestre (curva viola). Al contrario, i modelli climatici (curva verde) mostrano per lo più un riscaldamento continuo di circa 1 °C da 10000 anni fa a seguendo da vicino non quello che appare essere il vero forzante principale del clima – la variazione della luminosità solare dovuta alla variazione dell’obliquità della Terra, ma l’aumento osservato dei gas serra. Liu et al. (2014) hanno commentato la grave discrepanza tra le osservazioni e le previsioni del modello, concludendo che se l’andamento delle temperature durante l’Olocene è sufficientemente corretto – cosa del tutto verosimile perché lo stesso andamento con il periodo caldo dell’Ottimo dell’Olocene, è stato confermato da diversi studi indipendenti – il risultato evidentemente implica l’esistenza di “principali problemi nell’attuale generazione di modelli climatici”.

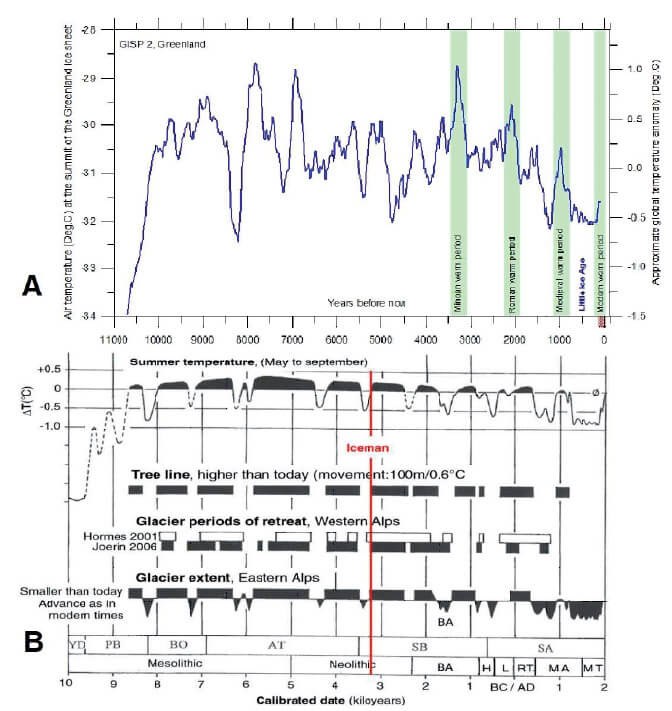

Infatti, è facile verificare che il problema non risiede nelle ricostruzioni della temperature dell’Olocene. A tale riguardo la Figura 6 mostra e confronta la ricostruzione della temperatura dell’Olocene dedotta dai dati ottenuti delle carote di ghiaccio GIPS2 in Groenlandia (Alley, 2004) e dai proxy climatici delle Alpi Europee (Kuts chera et al., 2017). Questi dati sono indipendenti e confermano l’esistenza dell’Olocene Climatic Optimum da circa 9500 a 5000 anni fa, quando, ad esempio, i ghiacciai sulle Alpi europee erano spesso significativamente più piccoli di quelli dei tempi attuali.

Inoltre, questi stessi dati rivelano anche l’esistenza di una grande oscillazione quasi millenaria che dura quasi per l’intero periodo dell’Olocene, cioè per circa 10000 anni. Queste oscillazioni hanno caratterizzato, ad esempio, il periodo caldo minoico (circa 3000 anni fa), il periodo caldo romano (circa 2000 anni fa), il periodo caldo medievale (circa 1000 anni fa) e ora la temperatura è quasi compatibile o leggermente inferiore a quella del periodo medioevale, quando i ghiacciai delle Alpi erano leggermente più piccoli di oggi. A questo proposito, un recente studio ha stabilito che durante il Medioevo i Vichinghi godevano di una Groenlandia calda quanto o più calda di oggi (Lasher & Axford, 2019). Pertanto, le ricostruzioni paleoclimatiche durante l’Olocene sembrano essere robuste e, quindi, il risultato mostrato in Figura 5 dimostra un grave fallimento nei modelli climatici.

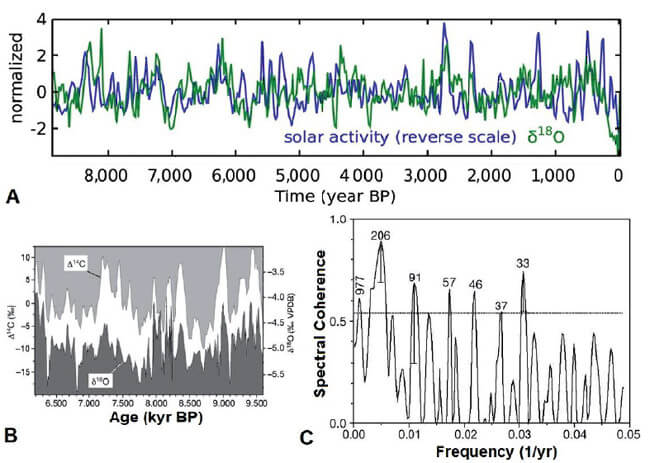

La Figura 5 mostra anche che i modelli non ricostruiscono le grandi oscillazioni climatiche millenarie osservate in tanti dati indipendenti, anche perché le registrazioni di CO2 e CH4 non mostrano tali oscillazioni. Al contrario, la Figura 7A mostra che la variabilità climatica durante l’Olocene e la sua grande oscillazione climatica millenaria è molto ben correlata agli indici di attività solare e delle variazioni del flusso di raggi cosmici, come misurati dagli isotopi 14C e 10Be (Bond et al., 2001; Kerr, 2001; Steinhilber et al., 2012; Kirkby, 2007). Lo stesso risultato è evidente anche in Neff et al. (2001) dove è stata dimostrata una una forte coerenza spettrale tra la variabilità solare e i dati sui monsoni in Oman tra 9.000 e 6.000 anni fa come la Figura 7B anche mostra, e in molti altri studi.

Figura 6- [A] Registrazioni della temperatura dell'olocene di GIPS2 (All ey, 2004) e [B] della temperatura estiva ed altre registrazioni climatiche riferite alle Alpi (Kutschera et al., 2017). La linea rossa indica la datazione del ghiacciaio, Ötzi, trovata nelle Alpi Venoste nel 1991 ad un'altitudine di 3210 m.

In particolare, la Figura 7C dimostra anche che i dati solari e quelli climatici presentano diversi picchi spettrali comuni, cioè presentano tante oscillazioni comuni.

Queste sono tipiche oscillazioni conosciute nella letteratura scientifica come il ciclo Eddy (800-1200 anni), il ciclo di Suess-de Vries (200-250 anni), il ciclo di Gleissberg (80-100 anni), il cluster spettrale 55-65 anni e altri. La cosa sorprendente è che tutte queste armoniche possono essere dedotte dai periodi orbitali astronomici dei pianeti del sistema solare (Scafetta, 2012c; Scafetta et al, 2016; Scafetta, 2020).

Figura 7 - [A] Prova di un'elevata correlazione tra una registrazione di attività solare in blu basata sul flusso di raggi cosmici e una registrazione δ18O della caverna di Dongge, Cina, in verde che rappresenta i cambiamenti del clima asiatico (Steinhilber et al., 2012). [B] Variabilità solare (14C) e registrazione dei monsoni in Oman tra 9000 e 6000 anni fa; [C] coerenza spettrale tra i due dischi (Neff et al., 2001)

In conclusione, numerosi documenti dimostrano che l’Olocene, ovvero il periodo interglaciale degli ultimi 11700 anni, è stato caratterizzato da un periodo caldo da circa 9500 a 5000 anni fa e da allora si è raffreddato negli ultimi 5000 anni a causa dei cambiamenti di insolazione dovuti all’evoluzione dell’obliquità dell’asse terrestre. Tuttavia, è altrettanto evidente che le variazioni note nei gas a effetto serra non sono in grado di spiegare i cambiamenti climatici durante l’Olocene che includono anche delle oscillazioni quasi millenarie osservate durante tutto questo periodo che i modelli ignorano totalmente.

Si è persino osservato che i cambiamenti di concentrazione di CO2 e CH4 sono negativamente correlati all’andamento della temperatura per la maggior parte dell’Olocene.

D’altro canto, le prestazioni dei modelli climatici nel riprodurre i cambiamenti climatici dell’Olocene sono chiaramente insoddisfacenti. Questi modelli non riproducono la dinamica osservata nei dati climatici ma, al contrario, semplicemente seguono l’aumento monotonico delle concentrazioni dei gas serra. Tuttavia, i dati chiaramente mostrano un andamento più correlato al forzante orbitale che induce una variazione dell’insolazione dovuto alla variazione dell’inclinazione dell’asse della Terra – uno dei

cicli di Milancovich che è lungo circa 41000 anni – ed altre forzanti solari che mostrano le stesse oscillazioni climatiche dalla scala multidecennale a quella multimillenaria. Tutto questo conferma che i modelli climatici attuali hanno una sensibilità troppo elevata ai cambiamenti nei gas serra come l’anidride carbonica e il metano. Allo stesso tempo, essi sottostimano notevolmente gli effetti climatici delle forzanti orbitali e solari.

Il clima dal Medioevo a oggi vs. le previsioni dei modelli Il confronto tra i dati climatici e le simulazioni dei modelli dal 1000 d.C. al 2000 d.C., e il modo con cui le evidenze sono cambiate negli ultimi vent’anni è molto istruttivo e va capito bene anche perché spiega gran parte dell’attuale popolarità dell’AGWT. In breve, intorno al 2000 si è affermato e creduto che i modelli climatici fossero stati

sufficientemente convalidati. Questo oggi non può più essere considerato valido. Tuttavia, sin dal 2000 tale affermazione è stata ampiamente divulgata nei mass-media fino ai nostri giorni. Ad esempio, si può ricordare il popolare documentario del 2006 di Al Gore, l’“Inconvenient Truth”. Tale credenza è anche alla base di ripetute affermazioni quali “il dibattito è finito”, “la scienza è completa” e “la comunità scientifica ha raggiunto il consenso” sul fatto che il riscaldamento dell’ultimo secolo è dovuto alle emissioni antropiche e solo ad esse: affermazioni che, come stiamo vedendo, sono del tutto prive di

un autentico fondamento scientifico. Esse si basano solo su una comprensione acritica e parziale delle conoscenze scientifiche che negli ultimi venti anni sono evolute notevolmente. Vediamo cosa è successo intorno al 2000, e come la situazione è poi cambiata fino ai giorni nostri.

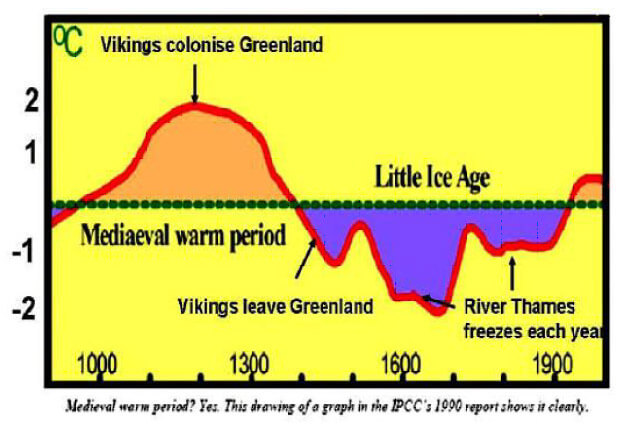

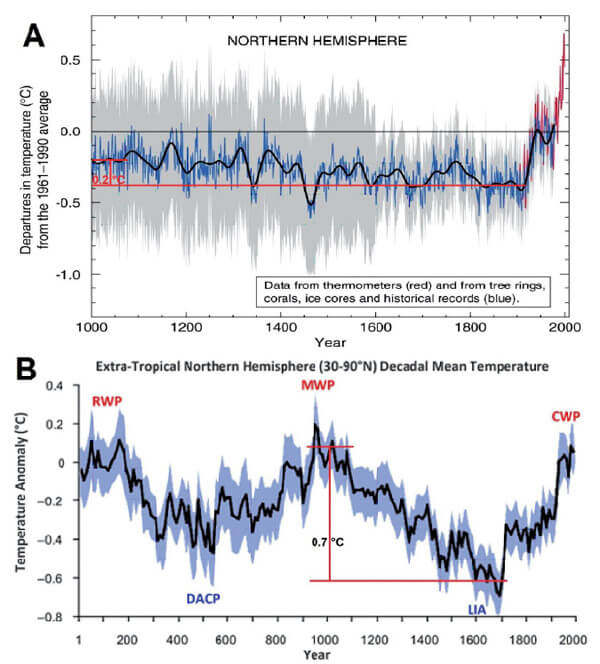

Prima del 2000 l’accordo generale tra gli scienziati del clima e i geologi era che la variabilità climatica naturale negli ultimi 1000 anni non poteva essere spiegata dalle variazioni di gas serra come il CO2 perché i dati mostravano una grande variabilità preindustriale con un periodo medievale piuttosto caldo dal 900 al 1400 circa, seguito da un periodo piuttosto freddo noto come la Piccola Era Glaciale dal 1400 al 1850: vedi la figura di sopra.

Al contrario, le registrazioni dei gas serra mostravano durante lo stesso periodo una variabilità molto modesta. La variabilità solare, invece, si correlava molto meglio con in dati climatici e spiegava la maggior parte della variabilità climatica osservata (Eddy, 1976; Hoyt & Schatten, 1993). In ogni caso, qualsiasi cambiamento nella concentrazione atmosferica di GHG prima del 1900 dovrebbe essere considerato un feedback naturale ai cambiamenti climatici dovuti ad altri forzanti. Questa comprensione del sistema climatico era piuttosto popolare tra i geologi e gli scienziati del clima, come confermato anche nel primo Rapporto scientifico dell’IPCC sui cambiamenti climatici pubblicato nel 1990-1991.

Tuttavia, nel terzo rapporto di valutazione dell’IPCC pubblicato nel 2001, si affermò che la variabilità climatica preindustriale dal Medioevo al 1900 era stata piuttosto modesta. Questa conclusione si basò su una nuova (per il 2000) ricostruzione della temperatura dell’emisfero nord che è raffigurata nella Figura 8A (Mann et al., 1999; IPCC, 2001). Questa ricostruzione paleoclimatica dell’emisfero settentrionale mostra una quasi stabilità climatica dal 1000 d.C. al 1900 d.C. quando si osserva una variazione di appena circa 0,2 °C, con la quale il periodo caldo medievale è stato cancellato, seguito da un riscaldamento improvviso e senza precedenti dal 1900 al 2000. A causa di questa forma peculiare nella sequenza dei dati termici, questa ricostruzione della temperatura climatica degli ultimi 1000 anni è stata etichettata come la “mazza da hockey”.

Allo stesso tempo, i modelli climatici disponibili durante quello stesso periodo furono dichiarati sufficientemente convalidati perché erano stati in grado di predire una variazione della temperatura climatica dell’ultimo millennio a forma da “mazza da hockey”. Questi modelli hanno interpretato che il cambiamento climatico molto modesto osservato dal 1000 d.C. al 1900 d.C. seguito da un brusco riscaldamento dal 1900 al 2000 potesse essere spiegato principalmente dai forzati dedotti dai gas serra che nel 20° secolo mostrano una impennata dovuta alle emissioni antropiche. A tale riguardo, Crowley (2000) ha dichiarato la convalida dei modelli climatici affermando che “L’ottimo accordo tra modelli e dati nell’intervallo pre-antropogenico aumenta anche la fiducia nella capacità complessiva dei modelli climatici di simulare la variabilità della temperatura su scale più grandi”.

Infatti, l’andamento della temperatura a mazza da hockey è perfettamente coerente con quello osservato nella Figura 1A, dove è mostrato che i soli forzanti naturali sarebbero in grado di produce solo una modesta variabilità climatica. Questa circostanza supportava molto bene l’AGWT perché mostrava che i modelli climatici che la sostenevano fossero stati convalidati essendo stati in grado di predire correttamente l’ipotizzata variabilità climatica mostrata in Figura 8A (cfr. IPCC, 2001, 2.3.4, p. 136).

Tuttavia, quello che non si conosce bene perché spesso non divulgato dai massmedia è che appena pochi anni dopo, McIntyre e McKitrick (2003) hanno presto messo in evidenza alcuni gravi errori nella metodologia statistica usata da Mann et al (1999) nel ricostruire la loro ormai famosa temperatura a mazza da hockey. In aggiunta, sin dal 2005 sono state proposte ricostruzioni alternative e piuttosto diverse della temperatura dell’emisfero settentrionale (Moberg et al., 2005; Mann et al., 2008; Ljungqvist, 2010; Christiansen & Ljungqvist, 2012). La Figura 8B mostra una di queste ricostruzioni

paleoclimatiche (Ljungqvist, 2010) ed appare totalmente diversa dal grafico a mazza da hockey mostrato in Figura 8A. In seguito a queste scoperte, la scienza che circonda il grafico della temperatura a forma di mazza da hockey è stata etichettata come una grande “illusione” (Montford, 2010) anche se ancora ai giorni nostri tale ricostruzione – oggi totalmente discreditata – continua ad apparire i giro.

Figura 8 - Il confronto tra [A] la ricostruzione della temperatura del ‘bastone da hockey’ si è sviluppato intorno al 2000 (Mann et al., 1999) e [B] una recente ricostruzione della temperatura nell'emisfero settentrionale che mostra una variabilità naturale molto più ampia (Ljungqvist, 2010). Nota le diverse ampiezze del raffreddamento (0,2 ° C contro 0,7 ° C) tra il Periodo caldo medievale (MWP) e la Piccola Era Glaciale (LIA)

Le nuove ricostruzioni disponibili della temperatura superficiale globale confermano che il clima è stato caratterizzato da una grande oscillazione millenaria negli ultimi 2000 anni. Ad esempio, il raffreddamento osservato dal periodo caldo medievale (circa 1000 d.C.) alla Piccola Era Glaciale (1700 d.C.) è almeno 3-4 volte più grande (circa 0,7 °C) di quello mostrato nelle ricostruzioni della temperatura della mazza da hockey (circa 0,2 °C). Pertanto, queste nuove ricostruzioni della temperatura paleoclimatica hanno confermato gli studi paleoclimatici pubblicati prima del 2000, contraddicendo del tutto le ricostruzioni della temperatura a mazza da hockey.

Un’implicazione diretta ed evidente di queste nuove ricostruzioni paleoclimatiche degli ultimi 1000 anni è che le affermazioni come quelle di Crowley (2000), che hanno di fatto sostenuto la ragionevolezza dell’AGWT sono del tutto contraddette visto che le nuove ricostruzioni paleoclimatiche hanno riaperto la questione relativa alla convalida dei modelli climatici. Quindi, il problema principale torna ad essere: questi modelli climatici sono in grado di ricostruire i cambiamenti climatici del passato come il periodo caldo medievale? Si oppure No?

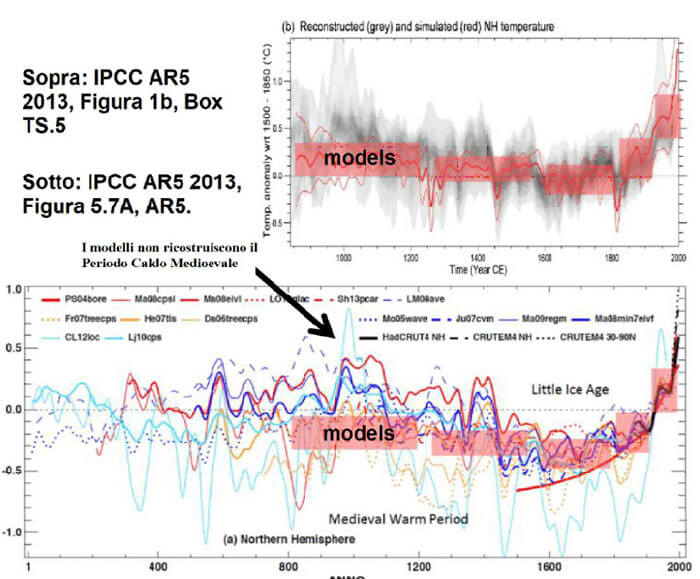

Figura 9 - Confronto tra le recenti analisi della ricostruzione della temperatura dell'emisfero nord (grigio) e le simulazioni dei modelli climatici dell'ultimo millennio (rosso e blu) pubblicate dall’IPCC (2013). Disponibili anche su https://www.ncdc.noaa.gov/global-warming/last-1000-years). Nota il fallimento dei modelli nel ricostruire il periodo caldo medievale intorno al 1000 d.C.

A tale riguardo si deve ricordare che ancora nel 2007 l’IPCC sostenne la validità della ricostruzione paleoclimatica a mazza da hockey mostrata in Figura 8A. Tuttavia dal 2013 le evidenze contro tale ricostruzione erano diventate così forti che l’IPCC abbandonò completamente tale grafico. Tuttavia, l’IPCC non evidenziò le implicazioni logiche di una tale capriola. Cerchiamo ora di spiegare le cose.

La Figura 9 riproduce due figure contenute nell’IPCC AR5 del 2013 confronta un insieme di recenti ricostruzioni del clima degli ultimi 1000 anni (aree grigie) rispetto alle simulazioni del modello climatico dell’ultimo millennio usando forzature di variabilità solare forte (rosso) o debole (blu) riportate nell’IPCC (2013). Appare quindi del tutto evidente che le simulazioni dei modelli climatici non riescono a ricostruire il Periodo Caldo Medievale suggerendo che questi modelli non implementano i veri meccanismi climatici che spiegano tali periodi caldi naturali. Questo risultato è molto significativo

perché il riscaldamento osservato dal 1900 iniziò in realtà all’inizio del XVIII secolo, cioè dal culmine della Piccola Era Glaciale.

Il caldo medioevale è accaduto ben prima che le emissioni antropiche di GHG avessero potuto avere un impatto significativo sul clima. Pertanto, non si può più escludere il fatto che il periodo di riscaldamento moderno possa essere stato anche il risultato di una tendenza al riscaldamento naturale a seguito di un’oscillazione quasi millenaria che i dati climatici e solari dimostrano abbastanza chiaramente durante tutto l’Olocene (Figure 6 e 7), ma che questi modelli non riproducono affatto.

Scafetta (2013a) ha mostrato che la grande variabilità climatica osservata fin dal medioevo può essere interpretata correttamente solo se gli effetti climatici della variabilità solare sul clima sono stati seriamente sottostimati dai modelli climatici per un fattore da 3 a 6 e, contemporaneamente, l’effetto climatico delle forzanti radiative, che includono i forzanti associati ai gas serra come il CO2, è stato sopravvalutato di almeno un fattore 2 o più dagli stessi modelli. Pertanto, o la luminosità solare è variata molto di più di ciò che mostra la funzione di forzante solare utilizzata dai modelli, o questi mancano di ulteriori forzanti solari e/o astronomici responsabili dei lunghi cicli climatici osservati nei dati.

In ogni caso, poiché i dati paleoclimatici pubblicati dallo stesso IPCC (2013) mostrano una variabilità climatica preindustriale significativamente maggiore di quella predetta dai modelli climatici usati dallo stesso, questi modelli si sono dimostrati del tutto insoddisfacenti nell’interpretare propriamente i cambiamenti climatici. Non solo questi modelli non possono essere considerati convalidati scientificamente, ma devono essere rigettati perché sottostimano notevolmente la variabilità naturale per secoli e millenni. Cercano, quindi, di compensare tale deficienza sovrastimando l’effetto antropico.

Quindi, uno non può che meravigliarsi dell’evidente contraddizione implicita nelle posizioni dell’IPCC nel proporre questi stessi modelli oppure, in ogni caso, modelli scientificamente equivalenti per fare previsioni future su cui basare politiche climatiche che le società del mondo dovrebbero implementare per “salvare” lo stesso da “catastrofi climatiche” che di fatto esistono solo nel mondo virtuale delle simulazioni al computer secondo modelli dimostrati non realistici perché incapaci di riprodurre i periodi caldi del passato.

Il clima dal 1850 al 2015 vs. le previsioni dei modelli

Valutare la capacità dei modelli climatici come i CMIP5 GCM di ricostruire correttamente i dati climatici osservati dal 1850-1900 al presente è molto più complesso perché l’elemento principale è solo il riscaldamento secolare osservato di circa 0,9 °C. I grafici tipicamente proposti sono simili alla Figura 1B che dà l’impressione di un buon accordo tra dati e modelli ma che, come spiegato, non ha di per se alcun valore scientifico perché, anche alla luce dei risultati discussi sopra, i modelli sono stati calibrati in modo tale da riprodurre tale accordo.

Infatti, questo buon accordo potrebbe essere accidentale perché una semplice tendenza al riscaldamento può essere riprodotta in molti modi alternativi. Come discusso in precedenza, l’incapacità dei modelli di ricostruire i periodi di riscaldamento degli ultimi millenni suggerisce che essi non implementano gli stessi meccanismi in grado di riprodurre tali periodi caldi, che non sembrano particolarmente diversi o più freddi di quello attuale. Questi periodi caldi si ripetono anche ogni 1000 anni circa e, quindi, un periodo caldo tra la fine del XX e il XXI secolo era prevedibile. Dall’altro lato, la grande incertezza nei valori dell’ECS discussa sopra permette di calibrare i parametri interni dei

modelli sopravvalutando il valore della loro ECS in modo tale da riprodurre approssimativamente il riscaldamento osservato dal periodo preindustriale semplicemente sfruttando il fatto che le emissioni antropiche di gas serra sono aumentate da allora.

Pertanto, senza considerare le evidenze climatiche dei secoli e millenni precedenti al 1900, è abbastanza difficile convalidare o testare questi modelli utilizzando solo i dati dal 1850 ad oggi. Al momento, qualsiasi test deve concentrarsi su scale temporali più brevi in cui l’abilità dei modelli osservati è ridotta e, pertanto, l’impresa è ancora più difficile.

A tale riguardo, per quanto riguarda una possibile divergenza statistica tra i dati e le tendenze climatiche simulate, nel 2009 i sostenitori di AGWT hanno proposto un test. Essi hanno affermato che: “Le tendenze quasi zero e persino negative sono possibili per intervalli di un decennio o meno nelle simulazioni, a causa della variabilità climatica interna del modello. Le simulazioni escludono (a livello del 95%) tendenze zero per intervalli di 15 anni o più, suggerendo che è necessaria un’assenza osservata di riscaldamento di questa durata per creare una discrepanza con il tasso di riscaldamento

attuale previsto” (Knight et al., 2009). Meehl et al. (2011) hanno mostrato che i GCM potevano simulare periodi di discontinuità attraverso l’assunzione occasionale di calore proveniente dalle profondità oceaniche, simulando, in tempi casuali, una temperatura costante fino a un decennio nonostante un forzante antropico crescente. Pertanto, secondo i criteri propri dei sostenitori dell’AGWT, una divergenza tra osservazioni e modelli climatici che si verifica su una scala temporale superiore al decennio fornirebbe una evidenza sufficiente per invalidare un modello climatico come quelli usati per sostenere l’AGWT. Questo criterio esclude i test basati su scale temporali sub-decennali più brevi

come quelle che si riferiscono alle fluttuazioni di El-Nino, che questi modelli non sono in ogni caso capaci di riprodurre e predire per costruzione.

Pertanto, è necessario concentrarsi sulle scale decennali e multi-decennali e verificare se i modelli climatici possono correttamente ricostruire i cambiamenti climatici su queste scale temporali. Osservando attentamente la Figura 1B, i dati sembrano caratterizzati da una grande oscillazione con un periodo di circa 60 anni che i modelli non riproducono. In effetti, le seguenti tendenze sono piuttosto evidenti nei dati di temperatura: i periodi di 30 anni 1850-1880, 1919-1940 e 1970-2000 furono caratterizzati da un evidente riscaldamento; i periodi 1980-2010, 1940-1970 furono caratterizzati da un

evidente raffreddamento; dal 2000 la temperatura superficiale globale è stata pressoché stazionaria anche se il 2015-2016 è stato particolarmente più caldo degli anni precedenti a causa di un forte evento di riscaldamento dovuta al fenomeno oceanico del El-Nino (Scafetta et al., 2017b).

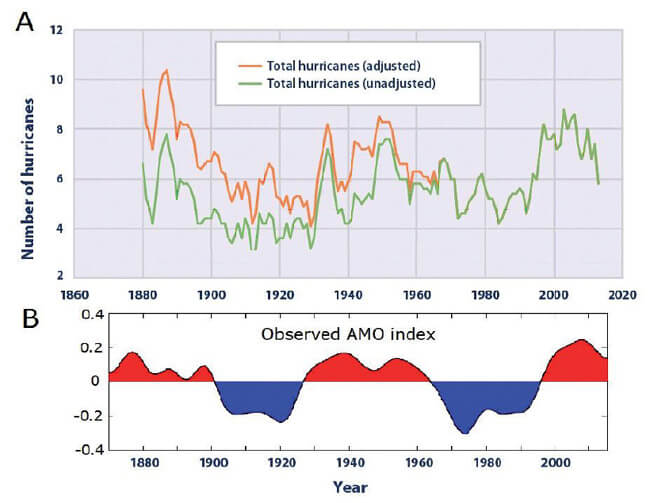

La presenza di questa grande modulazione di 60 anni nel sistema climatico, che risulta pure nell’analisi di coerenza spettrale mostrata in Figura 7C, è stata confermata da un numero molto elevato di lavori scientifici (Scafetta, 2010; 2012a; 2012b; 2013a; 2013b; 2014; 2016; Gervais, 2016; Wyatt & Curry, 2014; le loro citazioni e molte altre). In effetti, un’oscillazione di quasi 60 anni è stata trovata in diversi record climatici, alcuni dei quali persino lunghi diversi secoli o millenni. Essi includono dati di temperatura globale e regionale, registri di precipitazioni, registri del livello del mare, registri di indici climatici dell’Atlantic Multidecadal Oscillation, della Pacific Decadal Oscillation, della Noth Atlantic Oscillation, in vari dati di registrazioni climatiche come le carote di ghiaccio, gli anelli degli alberi, sedimenti e in molti altri.

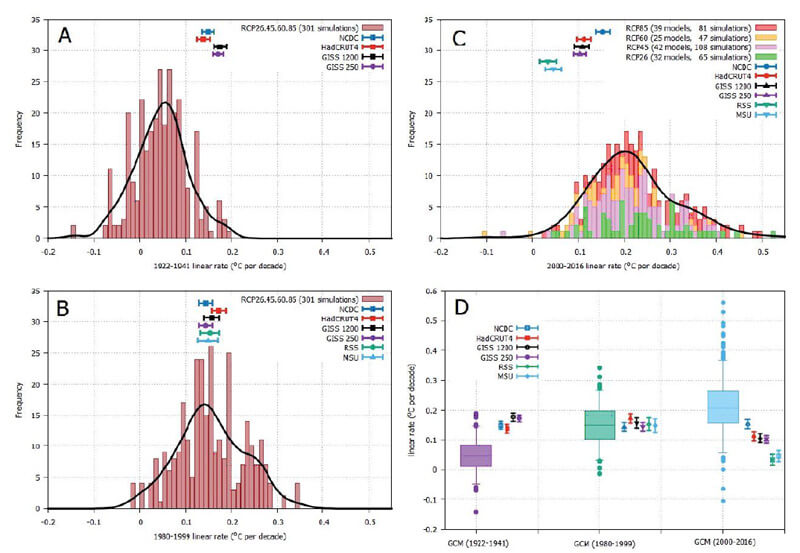

Figura 10 - [A, B, C] Distribuzione degli andamenti della tendenza lineare di 300 singole simulazioni GCM rispetto alle sei registrazioni di temperatura nei tre intervalli temporali Jan/1922 - dic/1941, Jan/1980 - dic/1999, e gennaio/2000-dic/2016. [D] Diagrammi percentuali degli stessi: gli intervalli statistici dei grafici a barre sono 5%, 25%, 50%, 75% e 95%. Si noti la grave divergenza del modello dai dati durante i periodi 1922-1941 e 2000-2016.

La Figura 1B e la Figura 10 mostrano che i modelli sottostimano il riscaldamento osservato dal 1910 al 1940 (quando il contributo antropico era quasi trascurabile) e sopravvalutano quello osservato dopo il 2000 (quando esisteva una forzatura antropogenica molto forte). Inoltre il riscaldamento del periodo 1922-1941 (quando le emissioni antropiche erano minime) corrisponde quasi esattamente a quello del periodo 1980-1999 (quando le emissioni antropiche sono cresciute notevolmente).

Questa situazione è stata studiata in dettaglio ad esempio in Scafetta et al. (2017a) in cui sono state confrontate le tendenze al riscaldamento di diverse centinaia di simulazioni CMIP5 con quelle di sei misurazioni di temperatura negli intervalli di 20 anni 1922-1941, 1980-1999 e 2000-2016. I risultati degli istogrammi mostrati nella Figura 10, indicano che la discrepanza tra i modelli e i dati nei periodi 1922-1941 e 2000-2016 è piuttosto evidente con una confidenza statistica superiore al 95%. Questo risultato suggerisce che il buon accordo osservato nel periodo 1980-1999 è casuale e probabilmente dovuto solo a un’attenta calibrazione dei parametri interni dei modelli come vedremo in seguito.

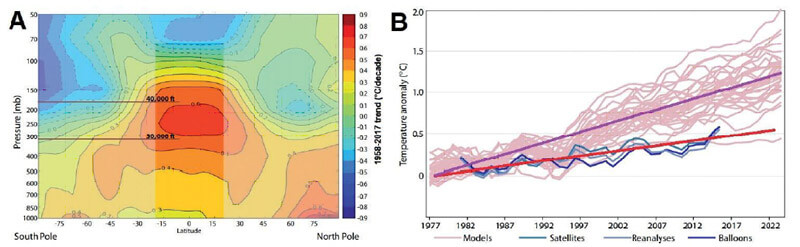

Il fallimento dei modelli nel ricostruire correttamente la tendenza della temperatura quasi stazionaria dopo il 2000 è dimostrato anche dalle misurazioni della temperatura troposferica. Infatti, negli ultimi decenni, i modelli climatici hanno previsto una regione calda, cioè un riscaldamento ingrandito della troposfera ad una quota superiore a circa 10 km sopra i tropici e l’equatore: vedi Figura 11A.

Figura 11 - [A] Modello di tendenza del riscaldamento della troposfera previsto in un modello climatico canadese dal 1958 al 2017. L'asse orizzontale mostra la latitudine, l'asse verticale mostra l'altitudine e il colore mostra la magnitudine della tendenza al riscaldamento. [B] Modelli tropicali di temperatura medio-troposferica (rosa) contro vari set di dati osservativi (sfumature di blu). Adattato da McKitrick & Christy (2018). Si noti la divergenza del modello di dati nell'andamento della temperatura con la significativa sovrastima dei modelli.

La presenza di questo hot-spot è abbastanza importante perché indica che il feedback del vapore acqueo al forzante radiativo è modellato correttamente. Tuttavia, le misurazioni della temperatura troposferica non mostrano questo forte riscaldamento (Douglass et al., 2007; Christy et al., 2010) che suggerisce nuovamente o che le misurazioni della temperatura ottenute con misure satellitari e palloni sono fuorvianti (il che è altamente improbabile) o che i modelli climatici falliscono macroscopicamente non riuscendo a simulare correttamente il feedback del vapore acqueo e, pertanto, finiscono per sopravvalutare l’effetto dei gas serra antropici come il CO2. In quest’ultimo caso, i difetti dei modelli sarebbero fatali perché il feedback del vapore acqueo è il più importante tra i feedback climatici e senza di esso, i modelli prevedono solo un ECS moderato di circa 1,0 °C per il raddoppio di CO2 invece di circa 3 °C, come prevedono in media i CMIP5 GCM, o addirittura 4 °C come prevedono i CMIP6 GCM..

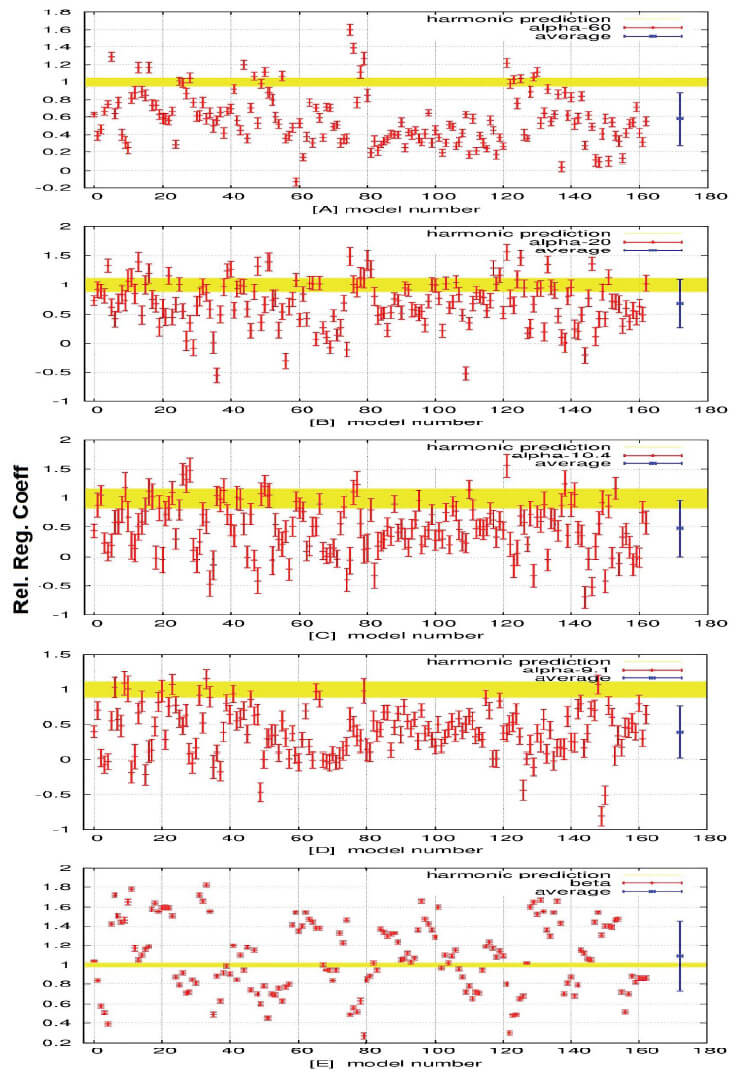

Figura 12 - Test multipli per determinare la capacità delle simulazioni dei CMIP5 GCM nel riprodurre le oscillazioni climatiche osservate con periodi di 9,1 - 10,4 - 20 e 60 anni più la tendenza al rialzo quadratica dal 1860 al 2012. L'area gialla attorno al valore 1 corrisponde alle osservazioni entro un errore di 1-s, i punti rossi sono i risultati dei modelli. Le barre blu sono i valori dell'insieme con relative barre di errore relative ai modelli.

La Figura 11B che confronta l’andamento della temperatura osservata nella troposfera rispetto alle previsioni del modello climatico CMIP5 è stata pubblicata in un recente lavoro di McKitrick & Christy (2018). La varianza tra le simulazioni e le tendenze della temperatura registrate sono evidenti e gli autori concludono che “ciò fornisce prove informative contro le principali ipotesi espresse nella maggior parte dei modelli climatici attuali”. Pertanto, anche questo risultato contesta l’affidabilità dei GCM, che hanno dimostrato più volte sopravvalutare il riscaldamento climatico che potrebbe causare un aumento della concentrazione atmosferica di CO2.

La discrepanza tra dati e modelli appare più evidente quando i dati vengono confrontati con le simulazioni prodotte da ogni singolo modello. Scafetta (2013a) ha mostrato un confronto così diretto rispetto ai 48 CMIP5 GCM , e ciascuno di essi ha mostrato prestazioni abbastanza scarse nel ricostruire correttamente le oscillazioni osservate nei record climatici sin dal 1860 ad oggi. In quell’occasione è stato dimostrato che i dati della temperatura superficiale globale (ad esempio HadCRUT, Morice et al., 2012) sono caratterizzati da una tendenza secolare di riscaldamento (che può essere approssimativamente catturata da una curva parabolica) più un insieme di oscillazioni

maggiori con periodi di circa 9.1, 10.4, 20 e 60 anni.

L’andamento della temperatura quasi costante dal 2000 ad oggi è uno degli effetti di queste oscillazioni, che sono presenti per l’intero periodo dal 1860 ad oggi. L’analisi statistica di queste oscillazioni ha concluso che nessuno dei modelli climatici CMIP3 e CMIP5 è in grado di modellarli dal 1850 (Scafetta, 2012a; 2013a).

La Figura 12 mostra tale analisi che testa la capacità di ciascuna delle 162 simulazioni climatiche CMIP5 disponibili prodotte da 48 diversi modelli nel ricostruire le quattro oscillazioni osservate (a 9.1, 10.4, 20 e 60 anni) e il riscaldamento della temperatura dal 1860. La figura mostra il coefficiente di regressione relativo, il che significa che l’area gialla attorno al valore di 1 rappresenta il modello osservato nei dati con un’incertezza di 1-, mentre i punti rossi sono i valori equivalenti dedotti dai modelli.

Più divergono da 1 peggio riproducono la corrispondente oscillazione o tendenza. La figura mostra chiaramente le scarse prestazioni di queste simulazioni climatiche, in particolare nel riprodurre l’oscillazione di 60 anni, che è fatale per la convalida di questi GCM perché si richiede che essi riproducano correttamente i cambiamenti climatici su scala decennale e superiore.

Questo fallimento nel ricostruire correttamente la variabilità climatica osservata dal 1850 ad oggi su scale decennali o più lunghe persiste anche nei modelli CMIP6 di nuova generazione. Ad esempio, la Figura 13 mostra diversi record di temperatura superficiale globale rispetto alle simulazioni prodotte dal modello E3SM (versione 1) (Golaz et al, 2019). La divergenza tra i dati e il modello dopo il 1950 è macroscopica. In particolare, il raffreddamento del vulcano è esagerato e dal 2000 questo modello prevede un tasso di riscaldamento di circa 0,4 °C/decennio, che è circa 4 volte più elevato di quanto mostrano i dati (cfr. Figura 10).

Golaz et al (2019) ha attribuito questa divergenza ad un troppo alto valore dell’ECS del modello che si è cercato di compensare con un forte effetto raffreddante di aerosol cosa che ha purtroppo finito per creare l’osservata divergenza. Pertanto, appare di nuovo evidente che i modelli non riescono a riprodurre la variabilità climatica naturale e cercano di ottenere il riscaldamento osservato dal 1850 ad oggi con opportune calibrazioni dei parametri interni del modello in modo da ottenere un apparente accordo tra le simulazioni e il riscaldamento osservato durante il XX secolo.

Figura 13 - Confronto tra osservazioni di NOAA NCDC (blu), NASA GISTEMP (verde), HadCRUT4 (grigio) ed E3SMv1 media e intervallo dell'insieme (rosso e arancione) (fonte: Golaz et al., 2019). Notare la grande divergenza del modello di dati dopo il 1950.

Un’ultima questione riguarda quanto bene i GCM CMIP5 ricostruiscano la temperatura media assoluta della Terra. Le figure precedenti tracciano solo le simulazioni GCM nella scala delle anomalie della temperatura, cioè rispetto a un valore medio durante un certo periodo, ad esempio il 1961-1990 o altro. Durante il XX secolo, la temperatura media della Terra era di circa 14-15 °C. La Figura 14 confronta due dati globali di temperatura superficiale nelle scale assolute prodotte da NCDC e Berkeley BEST

(disponibili su Climate Explorer) con tutte le simulazioni CMIP5.

La figura mostra che nella scala assoluta le simulazioni al computer forniscono temperature medie molto diverse: alcuni modelli mostrano valori medi di circa 12-13 °C mentre altri mostrano valori medi di 15-16 °C. Questo risultato sembra abbastanza insoddisfacente perché un errore di 3 °C nella temperatura assoluta è un’incertezza troppo grande per interpretare correttamente i cambiamenti climatici osservati.

Possono essere discussi molti altri casi che si concentrano su climi locali, piuttosto che globali. Ad esempio, Scafetta & Mazzarella (2015) hanno studiato i dati di estensione delle aree di ghiaccio marino dell’Artico e dell’Antartico rispetto ai dati misurati e modellati sulla temperatura dal 1980. È stato dimostrato che mentre l’Artico si sta riscaldando approssimativamente come previsto dai modelli climatici, nell’Antartico la regione marina si è raffreddata. La tendenza al raffreddamento osservata in Antartide contraddice in modo significativo il riscaldamento previsto dai GCM CMIP5 durante lo stesso periodo e nella stessa regione.

Figura 14 - Confronto tra registrazione della temperatura superficiale globale e le simulazioni dei GCM CMIP5 nella scala di temperatura assoluta.

La Figura 15 mostra un altro importante caso di studio locale confrontando il numero di uragani atlantici osservati e stimati dal 1878 al 2015 (Vecchi & Knuts, 2011) e l’oscillazione multidecadale atlantica, che è la temperatura della superficie del mare Atlantico, linearmente ridotta, tra l’equatore e la Groenlandia. Questi dati mostrano chiaramente un ciclo di 60 anni molto forte dal 1878 al 2015. Tuttavia, la stessa

oscillazione manca nei record di emissioni antropiche mostrate nella Figura 3. Quindi il fatto che eventi estremi come gli uragani siano aumentati dal 1980 al 2005-2010 non implica affatto che ciò sia dovuto all’uomo, come spesso si sente dire. La figura chiaramente mostra che l’aumento di tale attività ciclonica è parte di un ciclo naturale di circa 60 anni con equivalenti picchi di attività anche negli anni 1880-1890 e 1940-1950. I modelli climatici non riproducono questa oscillazione di 60 anni osservata in molte regioni della Terra e finiscono con il fraintendere le vere cause fisiche del cambiamento

climatico che appare in gran parte controllato da cicli naturali indipendenti dall’uomo.

Tutte le evidenze discusse sopra suggeriscono che il sistema climatico è più complesso di quanto ipotizzato dagli attuali modelli climatici adottati dall’IPCC per sostenere l’AGWT. L’effetto solare appare significativamente sottovalutato e gli effetti delle forzanti radiative sembrano significativamente sovrastimati di almeno un fattore due.

Come ultima osservazione ricordo che i grafici di simulazione dei modelli medi di insieme, in cui le simulazioni di tutti i modelli sono tracciati insieme in una scala di anomalie della temperatura come nella Figura 1, non devono essere interpretati come il risultato di una sorta di super-modello climatico, perché è solo una costruzione statistica che può nascondere più facilmente i difetti dei singoli GCM. Potrebbe essere possibile che un modello ricostruisca meglio un periodo specifico e un altro modello ricostruisca meglio un altro periodo. Quando le simulazioni dei due modelli sono tracciate insieme sullo

stesso grafico usando lo stesso colore per le curve, dà l’impressione che questa immagine sovrapposta si sovrapponga meglio ai dati e, quindi, che i modelli ricostruiscano i dati di temperatura ma, in realtà, non lo fanno.

Figura 15 - [A] Numero di uragani che si sono formati nell'Oceano Atlantico del Nord ogni anno dal 1878 al 2015. La curva arancione mostra come il conteggio totale nella curva verde può essere regolato per tentare di spiegare la mancanza di aeromobili e osservazioni satellitari nei primi anni (Vecchi & Knutson, 2011). [B] Oscillazione multidecadale atlantica. Nota la comune oscillazione dei 60 anni.

UN MODELLO CLIMATICO SEMI-EMPIRICO BASATO SU OSCILLAZIONI NATURALI DI ORIGINE ASTRONOMICA

Le evidenze discusse sopra suggeriscono che gli attuali modelli climatici non interpretano correttamente i cambiamenti climatici. La grande incertezza nel valore dell’ECS (Fig. 4) consente facilmente di ricostruire il riscaldamento osservato dal 1850 ad oggi anche usando modelli difettosi. Tutto suggerisce che i parametri interni dei modelli siano stati scelti per compensare la mancanza attuale di conoscenza dei veri processi fisici che regolano i cambiamenti climatici con il fine di simulare il riscaldamento osservato fin dai tempi preindustriali usando le uniche forzanti che attualmente si conoscono che sono per lo più interpretate come principalmente antropiche.

Questa operazione ha generalmente portato a modelli climatici che prevedono valori ECS troppo alti.

Calibrazioni dei parametri liberi dei modelli climatici al fine di ottenere i risultati desiderati sono tipici, come ad esempio dimostrato nel capitolo 3.6 in Mauritsen et al. (2019) dove tale operazione viene spiegata in dettaglio ed applicata ai meccanismi di produzioni di nuvole che sono ancora molto incerti.

Questa metodologia ha ovviamente una sua logica scientifica ma solo se poi viene supportata da verifiche di convalida che confrontano le previsioni dei modelli con dati diversi da quelli usati per la calibrazione dei parametri interni degli stessi. Tuttavia, non appena vengono presi in considerazione periodi caldi precedenti all’attuale, varie oscillazioni climatiche, confronti regionali e altre considerazioni, i limiti di questi modelli appaiono evidenti. Quindi essi non modellano in modo appropriato alcuni meccanismi fisici interni (ad esempio riguardanti la fisica della formazione delle nuvole, la dinamica

della circolazione oceanica e atmosferica) e, inoltre, potrebbero mancare anche alcuni importanti forzanti climatici. Tutto ciò implica che la scienza del cambiamento climatico non è sufficientemente sviluppata per produrre modelli dinamici affidabili del tipo GCM.

Pertanto, per tentare di modellare i cambiamenti climatici dovrebbero al momento essere usati solo i modelli climatici empirici e semi-empirici che cercano di ricostruire direttamente la dinamica contenuta nei dati.

Scafetta (2010; 2013a) ed altri autori hanno dimostrato che l’esistenza di specifiche oscillazioni climatiche naturali come quelle di 60 anni implicano che almeno il 50% del riscaldamento osservato dal 1970 al 2000 è stato molto probabilmente indotto da esse. La stessa conclusione deriva da un’analisi dei record climatici disponibili sin dal medioevo. Quindi, i forzanti antropici possono al massimo avere contribuito solo il 50% del riscaldamento globale osservato nel XX secolo, non del 100% come sostenuto dai GCM CMIP5. Pertanto, l’ECS reale sembra essere almeno la metà di quello che i modelli CMIP5 prevedono, cioè intorno a 1,5 °C anziché 3 °C.

Quali potrebbero essere I meccanismi climatici mancanti? Come spiegato sopra, ci sono forti evidenze empiriche che essi abbiano a che fare con l’attività solare o con fenomeni astronomici che potrebbero regolare l’attività solare. Durante il periodo caldo medievale (c. 900-1300), l’attività solare era alta e il clima era caldo, durante la piccola era glaciale (c. 1400-1800) l’attività solare era generalmente bassa, come durante il Maunder (1645-1715) o Dalton (1790-1830) grandi minimi solari, e la temperatura era bassa (Eddy, 1976). Dal minimo solare di Dalton la tempertura è aumentata fino alla fine del XX secolo e studi empirici suggeriscono che potrebbe aver indotto almeno il 50% dell’osservato riscaldamento (Scafetta & West, 2006; Scafetta, 2009; 2011).

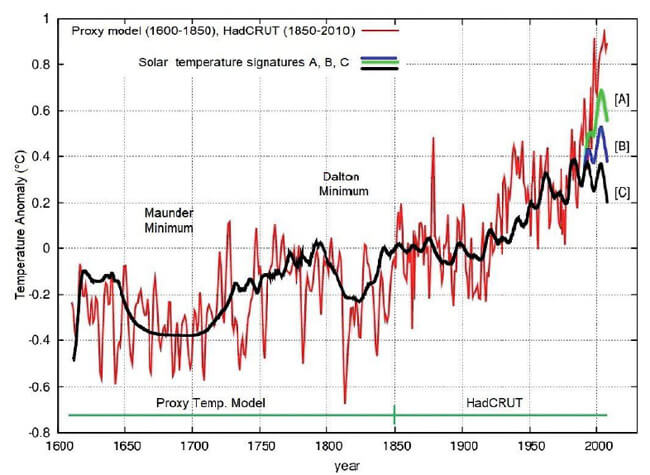

Figura 16 - Una stima della temperatura globale della superficie dal 1600 al 2010 utilizzando il modello di temperatura proxy globale di Moberg et al. (2005) fusa con la registrazione strumentale globale della temperatura superficiale HadCRUT dal 1850 al 2010. Le altre curve sono tre possibili firme climatiche della variabilità solare (Scafetta & West, 2006; Scafetta, 2009; 2011). Si noti che in media quasi la metà del riscaldamento osservato dal 1900 potrebbe essere dovuto al sole.

Ciò è mostrato nella Figura 16 che confronta una ricostruzione del cambiamento globale della temperatura superficiale dal 1600 al 2010 con ricostruzioni empiriche del segnale climatico indotto dalle variazione dell’attività solare come dedotto dal modello empirico.

In aggiunta, il sistema solare è caratterizzato da una serie di specifiche oscillazioni gravitazionali poiché i pianeti si muovono attorno al sole. Un’attenta analisi delle oscillazioni gravitazionali del sistema solare e del sistema di mareale indotto dal sole e dalla luna dimostrano che i dati astronomici e climatici condividono un gran numero di armoniche (ad esempio: Scafetta, 2010; 2012a; 2012b; 2013a; 2013b; 2016; 2018). Infatti, tutto nel sistema solare, incluso il sole stesso, dovrebbe tendere a sincronizzarsi con queste frequenze. Quindi, il sole oscillante e l’eliosfera potrebbero indurre cicli equivalenti nel sistema climatico perché esso deve sincronizzarsi con le sue forzanti armoniche esterne. Inoltre, anche il sistema sole/luna chiaramente agisce sul clima della Terra con le sue maree atmosferiche ed oceaniche. In conclusione, dovremmo aspettarci che il sistema climatico sia principalmente modulato da una serie di cicli complessi che rispecchiano quelli astronomici. L’idea, quindi, è verificare questa ipotesi per poter poi utilizzare queste stesse armoniche, derivabili direttamente dall’astronomia, per prevedere la componente armonica del clima, almeno su scala globale.

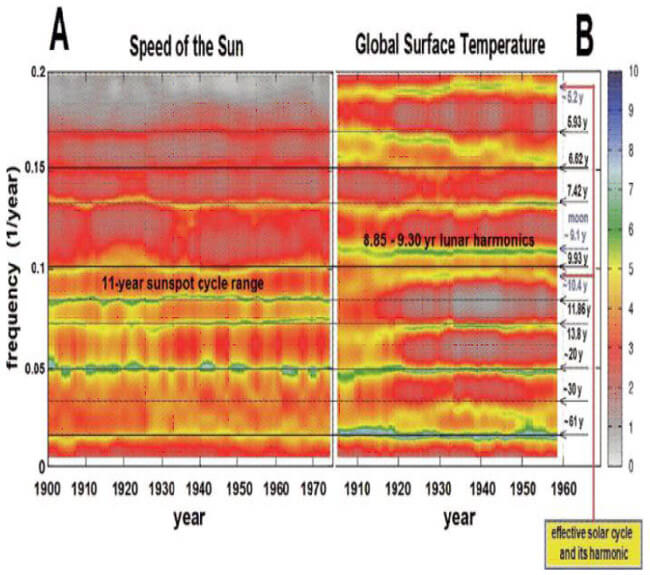

Questa teoria è difatti supportata da forti evidenze empiriche che utilizzano i dati solari e quelli climatici disponibili. La Figura 17 raffigura un confronto tra l’analisi spettrale continua della velocità del sole rispetto al baricentro del sistema solare – che è un buon indicatore per determinare le più importanti oscillazioni gravitazionali del sistema solare – e dei dati della temperatura superficiale globale (Scafetta, 2013a). Le metodologie spettrali continue ad alta risoluzione dimostrano che la coerenza spettrale tra i due record ha una confidenza statistica del 95% per le oscillazioni con i seguenti periodi: 6,6, 7,4, 14, 20 e 60 anni (Scafetta, 2016; 2018). Quindi, è evidente che il clima della Terra è determinato da una serie di forzanti armonici che hanno un’origine astronomica.

Figura 17 - Confronto tra l'analisi spettrale continua della velocità del sole rispetto al baricentro del sistema solare (a sinistra) e la registrazione della temperatura superficiale globale (a destra). (Fonte: Scafetta, 2013a).

La Figura 17 mostra anche che la temperatura è caratterizzata da un’oscillazione di quasi 9,1 anni, che non è presente nei dati del movimento del sole. Tuttavia, questa oscillazione è chiaramente un’oscillazione mareale perché questo periodo lo si ritrova nei cicli orbitali della luna: (1) il ciclo perigeo lunare è di 8,85 anni; (2) l’armonica principale del ciclo di eclissi detto di Saros (circa 18 anni) è di circa 9 anni; (3) l’armonica principale del ciclo nodale lunare (18,6 anni) di circa 9,3 anni (Scafetta, 2012a; Haigh et al., 2011).

Inoltre, l’oscillazione della temperatura variabile osservata tra i periodi astronomici di 10 e 12 anni è l’impronta delle misurazioni del ciclo delle macchie solari.

In quest’ultimo riguardo, c’è da sottolineare che il ciclo solare di 11 anni è limitato dal ciclo di marea di Giove-Saturno di 9,93 anni e dal ciclo di marea orbitale di Giove da 11,86 anni (Scafetta, 2012c), e la sua lunghezza è leggermente diminuita dal 1850 al 2000. Scafetta (2012c) ha dimostrato che la combinazione delle due precedenti oscillazioni planetarie di marea e del ciclo solare di 11 anni produce delle oscillazioni con un periodo di circa 115 e 983 anni. Queste lunghe oscillazioni sono sincrone con

oscillazioni equivalenti osservate nel clima e nei dati solari durante l’Olocene e specialmente negli ultimi 2000 anni. Infatti, una combinazione della funzione di marea generata da Venere, Terra e Giove sincronizza il ciclo delle macchie solari di 11 anni (cfr. Scafetta, 2012c), un fatto recentemente confermato anche da Stefani et al (2019).

Due studi recenti di Scafetta ulteriormente confermano la tesi di un influsso astronomico nel clima. Scafetta et al. (2019) studia le oscillazioni dell’eccentricità dell’orbita della Terra e di tutti gli altri pianeti del sistema solare. Sulle lunghe scale temporali trova che ad esempio l’eccentricità di Giove presenta grandi cicli di circa 60 e 900-960 anni che sono in accordo con equivalenti cicli che si osservano nel clima della Terra e del sole. Scafetta (2020) sviluppa un modello astronomico teorico per le oscillazioni a lungo periodo che si osservano sia nell’attività solare che nel clima della Terra e dimostra che le oscillazioni ad esempio mostrate in Figura 7B e 7C sono tutte particolari armoniche astronomiche che per le loro peculiari proprietà fisiche, cioè per la loro caratteristica di poter sincronizzare altri sistemi rotanti e generare risonanze, sono state chiamate Inequalità Invarianti Orbitali. Queste predicono con grande accuratezza anche il grande ciclo di Hallstatt, con un periodo di circa 2318 anni, che è il più lungo ciclo certo trovato durante l’Olocene sia nei dati solari che in quelli climatici (Scafetta et

al., 2016).

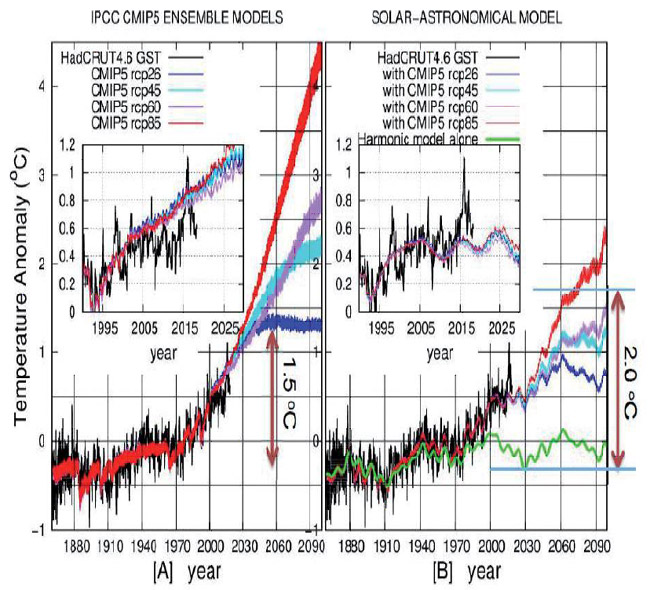

Scafetta (2010; 2013a) ha anche proposto di ricostruire i dati della temperatura globale superficiale dalla scala decennale a quella millenaria usando un minimo di 6 armoniche a 9.1, 10.4, 20, 60, 115 e 983 anni più un contributo antropico e uno vulcanico, che è stato estimato usando le simulazioni dei modelli climatici ma riducendone l’effetto per la metà secondo le stime empiriche. Infatti, come discusso in precedenza, la reale sensibilità climatica al forzate radiativo dovrebbe essere circa la metà di quanto ipotizzato dagli attuali GCM.

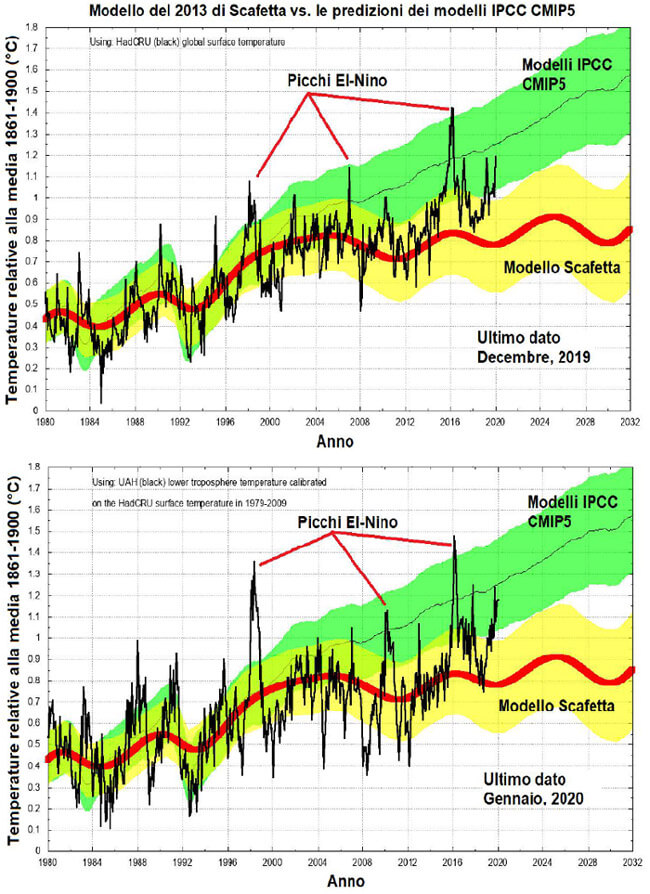

Le Figure 18 e 19 mostrano le temperature globali della superficie terrestre in nero e le confrontano con le simulazioni del modelli CMIP5 e del modello semi-empirico basato sui suddetti cicli: i dati usati sono quelli della temperatura globale della superficie HadCRUT4 (Morice et al., 2012) (Figura 18) e quelli della bassa troposfera UAH-MSU (Christy et al., 2007) (Figura 19). Si nota chiaramente che le prestazioni del modello semi-empirico basato su oscillazioni solare e astronomiche sono di gran lunga superiori rispetto a quelle dei modelli CMIP5 nella ricostruzione di due dati di temperatura

alternativi. Le migliori prestazioni del modello proposto da Scafetta nel 2013 sono evidenti per tutto il periodo ma diventano particolarmente manifeste dal 2000.

Bisogna sottolineare che il picco caldo 2015-2016 è stato causato da un forte evento dell’El-Nino, non correlato all’attività antropica il cui effetto è in parte enfatizzato anche nel 2020 perché questo segnale ha un periodo che varia in media intorno ai 4-5 anni (Scafetta e Mazzarella, 2015). A dispetto di questi picchi caldi, il modello semi-empirico prevede un riscaldamento piuttosto moderato fino al 2030-2040 e si prevede un riscaldamento massimo di 2,5 °C per il 2100 rispetto ai tempi preindustriali (1850-1900)

secondo lo scenario RCP 8.5.

Queste stime sono evidentemente più moderate di quelle allarmanti prodotte dai modelli CMIP5 dell’IPCC che nelle stesse condizioni prevedono un riscaldamento massimo di circa 5 °C per il 2100.

Pertanto, poiché il modello semi-empirico riproduce molto meglio le temperature passate mentre, come abbiamo visto in precedenza, i modelli CMIP5 sovrastimano l’effetto antropico sottovalutando quello naturale, è ragionevole ritenere che i futuri cambiamenti climatici saranno modesti e significativamente meno allarmanti rispetto a quelli associati al riscaldamento a 5 °C previsto dai modelli CMIP5.

Figura 18 - [A] Le quattro proiezioni medie dell'insieme CMIP5 rispetto al record GST HadCRUT4 (nero). [B] Il modello semi-empirico solare-astronomico. Aggiornato da Scafetta (2013a).

Figura 19 - Le temperature HadCRUT4 e le temperature satellitari UAH (nero) messe a confronto con le previsioni del modello Scafetta del 2013 (giallo) e quelle dei modelli CMIP5 dell’IPCC (verde).

CONCLUSIONI

Dal periodo pre-industriale 1850-1900 la temperatura superficiale globale è aumentata di circa 0,9 °C. Questo riscaldamento è stato interpretato usando modelli climatici come i CMIP5 GCM. La conclusione dedotta dalle loro simulazioni è stata che il riscaldamento osservato durante il XX secolo è stato quasi interamente indotto dalle emissioni antropiche prodotte dalla combustione di combustibili fossili. Gli stessi modelli sono stati quindi adottati per valutare le proiezioni climatiche per il XXI secolo e hanno concluso che nel 2100 la temperatura salirà rapidamente fino ad un massimo di 5 °C dal livello della temperatura preindustriale. Poiché questi scenari sono stimati pericolosi per diversi motivi, queste proiezioni sono utilizzate per giustificare costose politiche di mitigazione, cioè di riduzione di emissioni antropiche di gas serra con la speranza di ridurli sufficientemente al fine di prevenire tali ipotetici cambiamenti climatici catastrofici (IPCC, 2018).